White Paper

LLM Fine-Tuning

Einsatz von parameter-effizientem Fine-Tuning (PEFT)

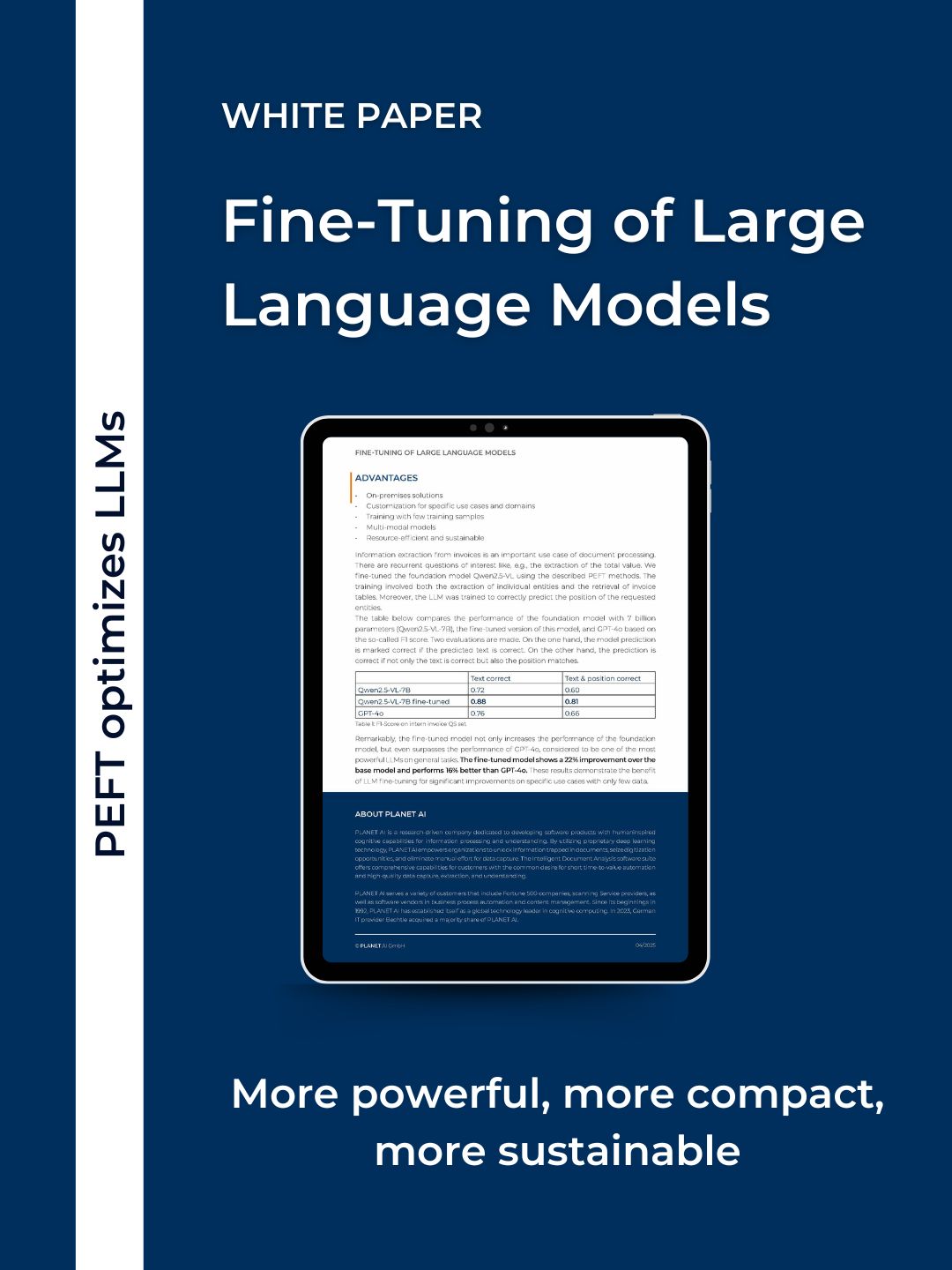

Große Sprachmodelle (LLMs), wie jene hinter ChatGPT, verfügen über umfangreiche Fähigkeiten, stoßen jedoch bei spezialisierten Aufgaben oft an ihre Grenzen. Durch den Einsatz von parameter-effizientem Fine-Tuning (PEFT) steigern wir die Leistungsfähigkeit von LLMs erheblich für spezifische Anwendungsfälle wie die Extraktion von Rechnungsdaten – und das mit minimalem Trainingsaufwand und geringen Ressourcen.

Unser Ansatz ermöglicht maßgeschneiderte, lokal einsetzbare KI-Lösungen, die nachhaltig, kosteneffizient und multimodal (Text und Bild) sind. Die adapterbasierte Tuning-Architektur sorgt für eine geringe Umweltbelastung und erlaubt gleichzeitig eine flexible Implementierung.

Multimodale LLM-Engines: Qwen2.5-VL-7B, Qwen2.5-VL-7B fine-tuned, GPT-4o